4月20日 AAAI联合IBM、蒙特利尔大学发布的AIGC教程《Beyond Human Creativity: A Tutorial on Advancements in AI Generated Content》参见IBM或AAAI.org官网, 可在线阅读地址。 教程共计305页、英文、150mb, 以下为诸位摘取全文中有精华内容, 方便非专业领域的朋友了解AI基本原理及运用常见。

教程结构 AI简介、AI文生文(LLM)、AI文生图(LGM)、AI生成代码、AI生成图表、总结与展望。

AI简介

- AI的运用领域:文生文(openai)、文生图(DALL.E)、生成代码(Github Copilot)、AI NPC(Nvidia convai)

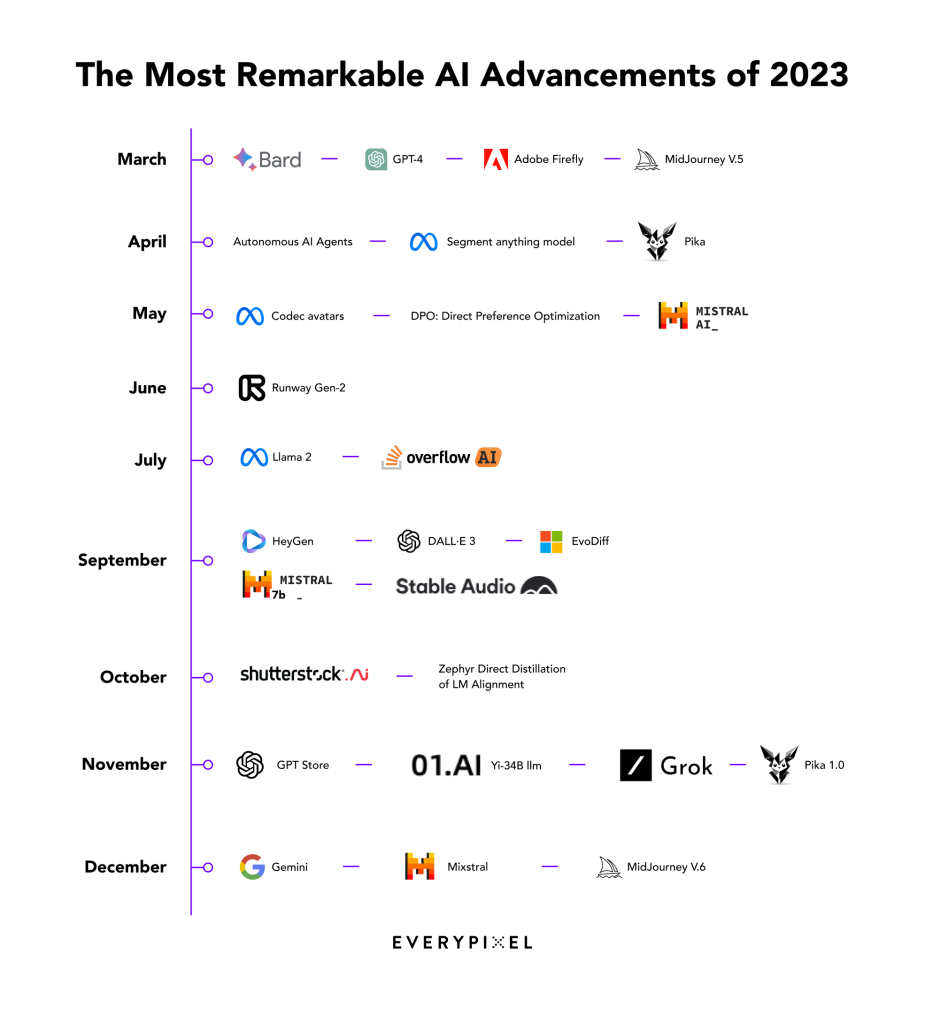

- 2023最具影响力的AI产品 https://journal.everypixel.com/2023-the-year-of-ai

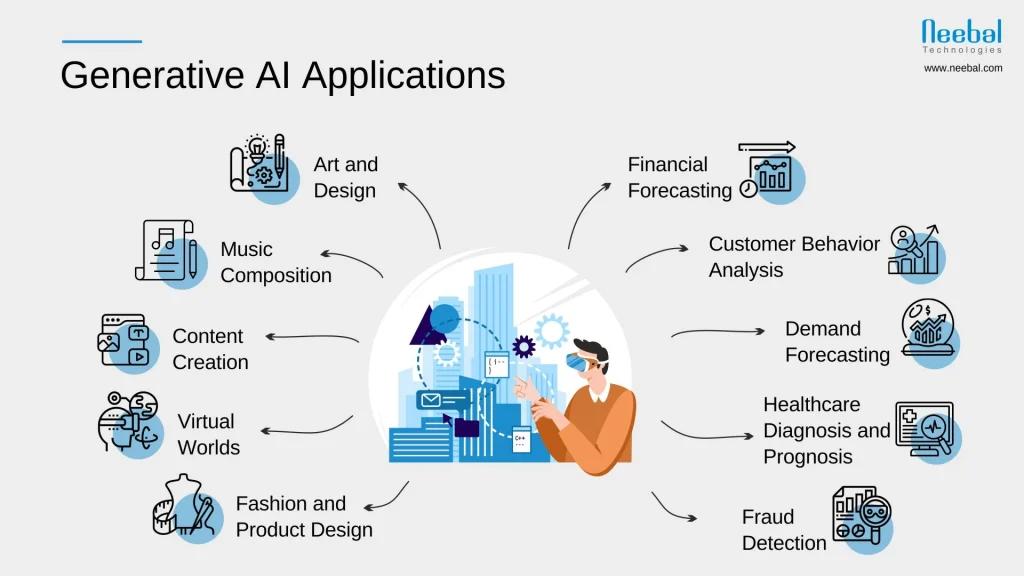

- AIGC有哪些冲击影响(PCG>UGC>AIGC, 领域:绘画、音乐、内容、虚拟现实、财务预测、用户行为分析等)

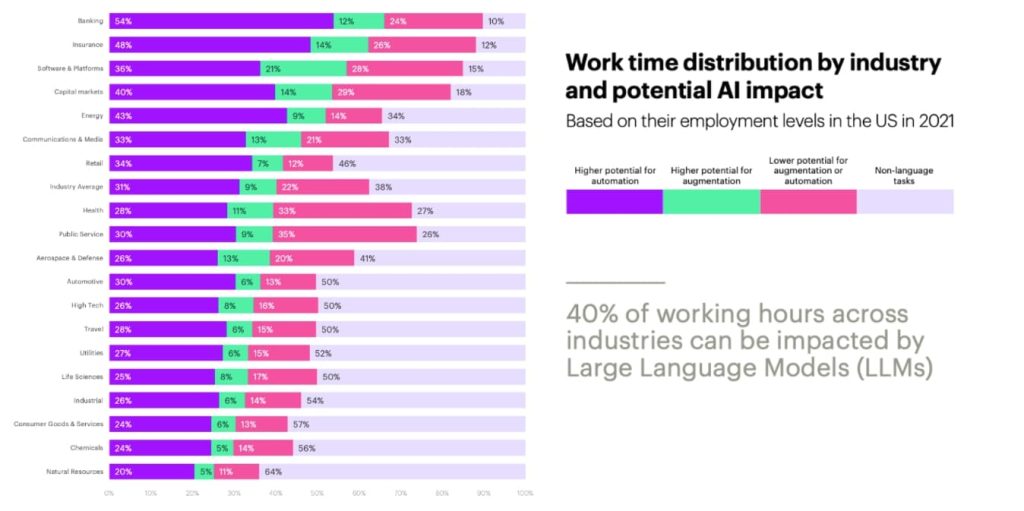

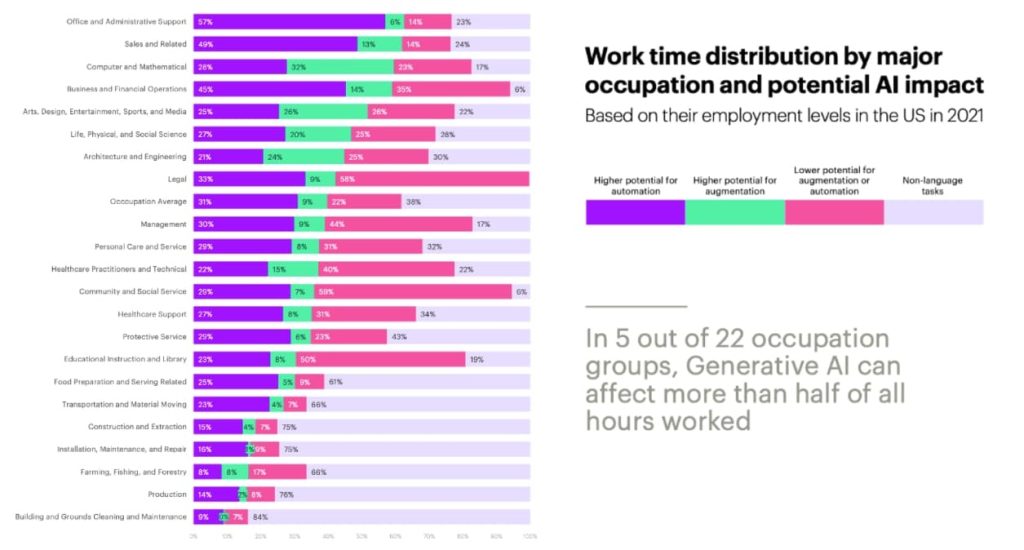

- AI对不同行业的冲击是不一样的(如律师行业100%文字工作,潜在替代性最高,建筑、制造、农业等可替代性很低)参见原文

- 为何此次AI冲击如此之大

- 模型的革新(数十年积累)

- 模型规模暴涨

- 硬件计算能力增长

- 数据源增长

文本AI LLMs

- 大语言模型(LLM)简介

- 自然语言处理(NLP)及其面临的挑战

- 何为自然语言处理(NLP)- 非常复杂的系统帮助计算机理解自然语言

- NLP的工作及其繁琐

- 多维度让NLP无比复杂(不同语种、数据来源、技术瓶颈)

- 能否使用未标签话的数据?

- 自然语言处理(NLP)及其面临的挑战

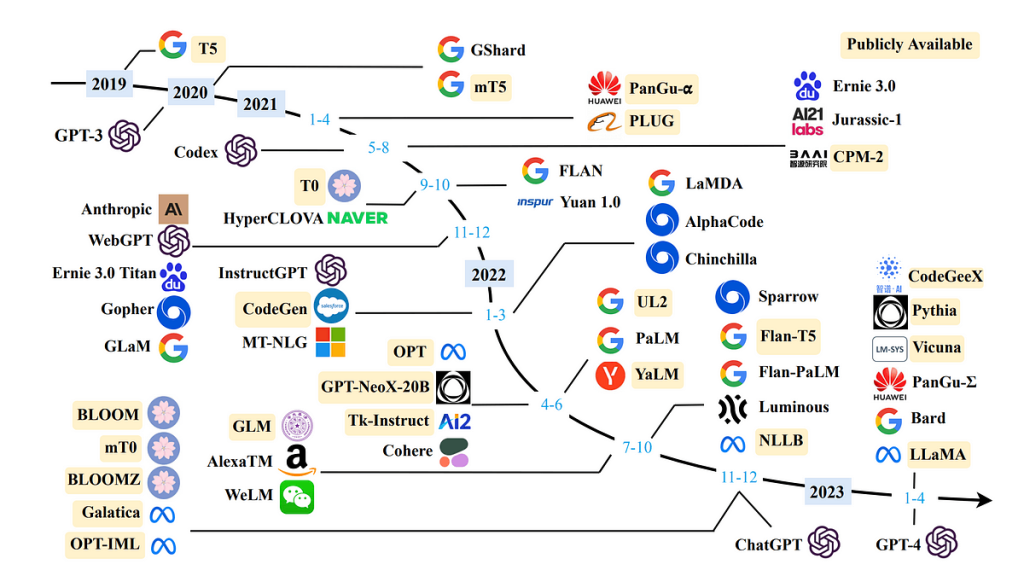

- 语言建模:一次范式转变

- 何为语言模型?(CLM:一种给定上下文预测下一个单词的单向语言模型。)

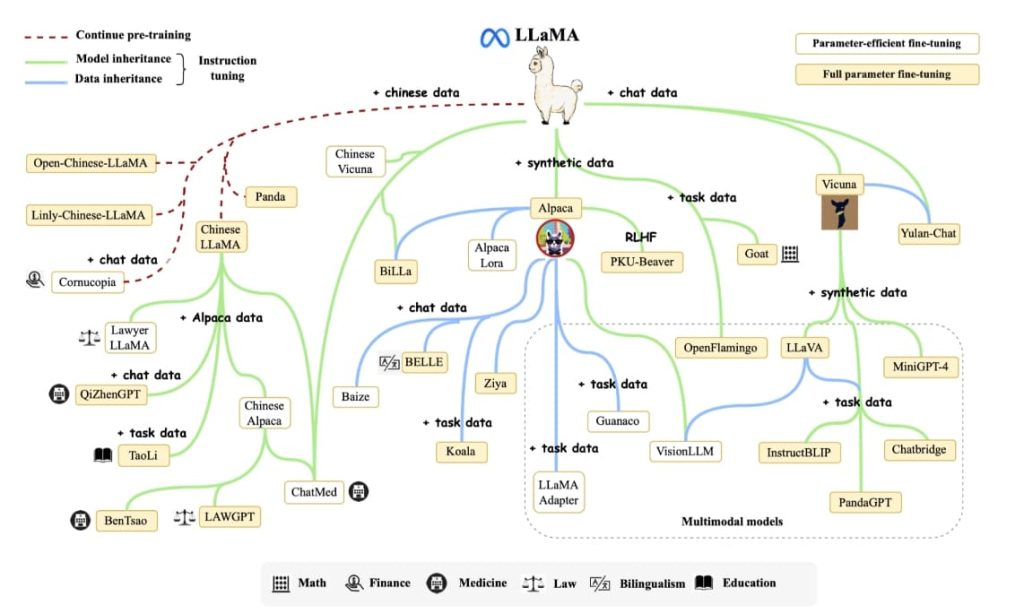

- 一个充满活力的开源生态系统是人工智能发展的关键驱动力(https://github.com/Hannibal046/Awesome-LLM?tab=readme-ov-file)

- 一个充满活力的开源生态系统是人工智能发展的关键驱动力

- 大语言模型(LLM)核心技术(预训练/可适应/工具化/评估)

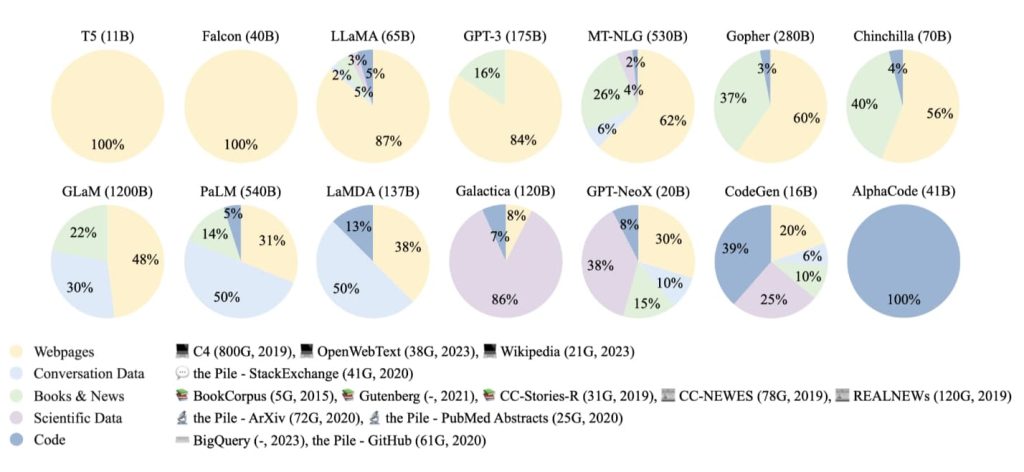

- 预训练(Pre-training):LLM从大量数据中学习,以理解和生成类似人类的文本,建立其基础知识。 预训练建立了LLMs能力的基础。预训练核心问题:数据准备、模型架构、模型训练.

- 利用(Utilization):为解决各种任务,为LLMs设计合适的提示策略。

- 上下文学习(In-context learning):以自然语言文本的形式制定任务。

- 思维链提示(Chain-of-thought prompting):让提示词中包含一系列中间推理步骤

- 适配(Adaptation): 通过特定数据集或参数对模型进行微调,以使其响应适应特定任务或领域.评估LLMs的3种基本能力类型:语言生成、知识利用、复杂推理

- 评估(Evaluation):评估LLM在其任务中的性能、准确性和可靠性。

- LLM的应用和未来发展方向(理解LLMs、改进LLMs、人工智能科学)

图像AI LGM

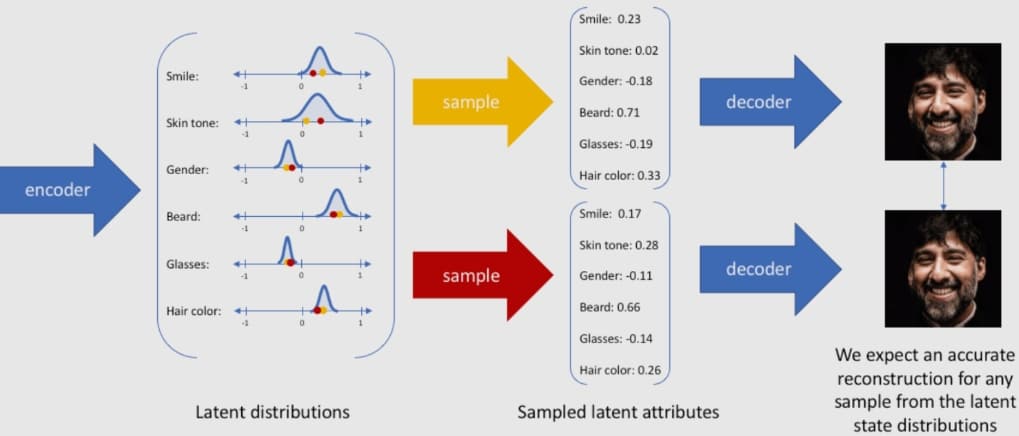

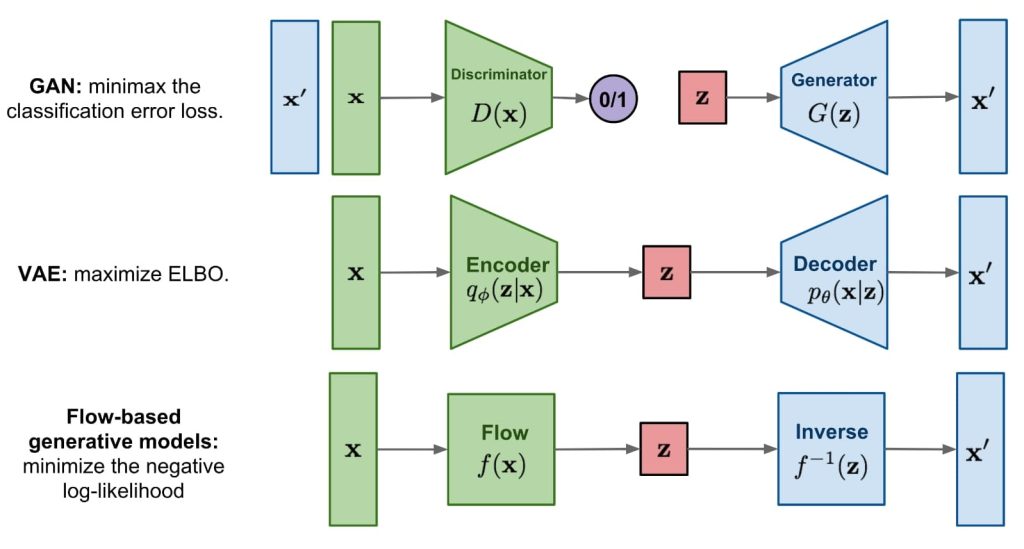

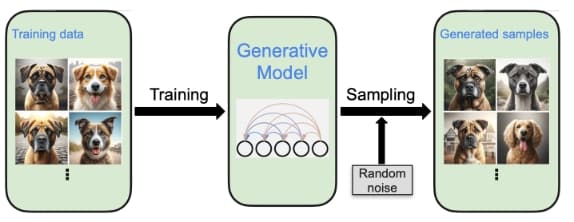

常见的图像生成模型:对抗网络(GAN)、VAE、流式模型(Flow-based generative models).

- 对抗网络(GAN),简单理解通过确认是否与生成目标相符来判断模型参数是否正确

- VAEs:捕捉世界的本质